총소유비용과 에너지 효율 개선으로 자본, 운영 비용 절감 효과 기대

텐서 병렬 처리로 개발자 개입과 모델 변경 없이 대규모 추론 수행

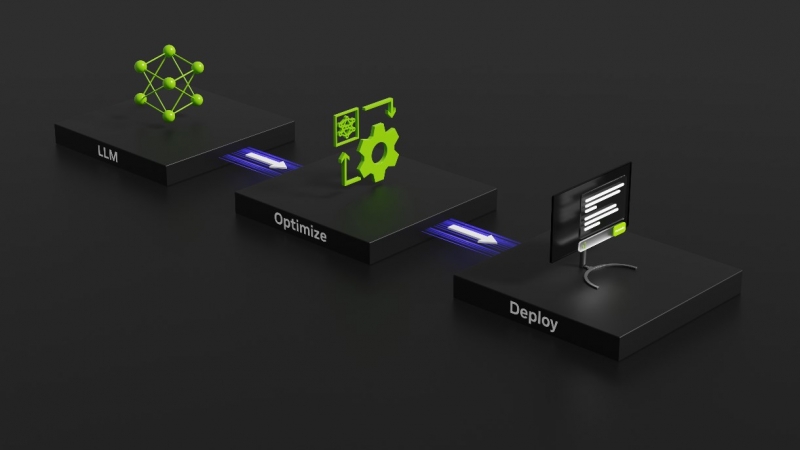

엔비디아 텐서RT-LLM(NVIDIA TensorRT-LLM)이 공개됐다. 텐서RT-LLM은 오픈 소스 모듈식 파이썬 API(Python API)를 통해 쉽게 맞춤화할 수 있다. 예를 들어, 모자이크ML은 텐서RT-LLM 위에 필요한 특정 기능을 원활하게 추가하고 추론 서비스에 통합했다.

데이터브릭스 엔지니어링 담당 부사장인 나빈 라오(Naveen Rao)는 "텐서RT-LLM은 사용이 간편하고, 토큰 스트리밍, 인플라이트 배칭(In-flight Batching), 페이지드 어텐션(Paged-attention), 정량화 등 다양한 기능을 갖추고 있으며 효율적이다. 이 솔루션은 엔비디아 GPU를 사용해 대규모 언어 모델 서비스를 위한 최첨단 성능을 제공하고, 고객에게 비용 절감 효과를 전달한다"고 말했다.

메타가 출시한 언어 모델 라마2(Llama 2)는 생성형 AI를 통합하려는 여러 조직에 배치됐다. 라마2에서 텐서RT-LLM은 A100 GPU에 비해 추론 성능을 4.6배 가속화했다. 총소유비용(TCO)과 에너지 소비도 절감할 수 있다. GPT-J 6B와 같은 소형 언어 모델에서 8배 성능 속도 향상으로 A100 기준 대비 총소유비용을 5.3배, 소비 에너지는 5.6배 절감할 수 있다.

마찬가지로 라마2와 같은 최신 대규모 언어 모델에서는 700억 개의 파라미터를 사용하더라도 고객은 A100 기준 대비 4.6배의 성능 속도 향상을 실현한다. 이로써 총소유비용은 3배, 소비 에너지는 3.2배 절감할 수 있다.

한편, 텐서RT-LLM에는 오늘날 프로덕션 환경에서 널리 사용되는 많은 대규모 언어 모델의 최적화되고 바로 실행 가능한 버전이 포함돼 있다. 여기에는 메타의 라마 2, 오픈AI(OpenAI)의 GPT-2 와 GPT-3, 팔콘(Falcon), 모자이크 MPT(Mosaic MPT), 블룸(BLOOM) 등 12가지가 포함되며, 모두 사용이 간편한 텐서RT-LLM 파이썬API로 구현할 수 있다.

텐서RT-LLM이 탑재된 엔비디아 H100 GPU(H100 GPU)를 사용하면 모델 가중치를 새로운 FP8 형식으로 쉽게 변환하고, 최적화된 FP8 커널을 자동으로 활용하도록 모델을 컴파일할 수 있다. 이는 호퍼 트랜스포머 엔진(Hopper Transformer Engine) 기술을 통해 가능하며, 별도로 모델 코드를 변경할 필요가 없다.

H100에 도입된 FP8 데이터 포맷을 통해 개발자는 모델을 정량화하고 모델 정확도를 저하시키지 않으면서 메모리 소비를 획기적으로 개선한다. FP8 양자화는 INT8 또는 INT4와 같은 다른 데이터 형식에 비해 높은 정확도를 유지하면서도 가장 빠른 성능을 달성하고 가장 간단한 구현을 제공한다.

엔비디아는 대규모 언어 모델 추론은 데이터 센터를 재편하고 있다. 정확도 향상과 함께 성능이 향상되면 기업의 총소유비용이 개선된다. 모델 혁신은 더 나은 고객 경험을 가능하게 해 더 높은 매출과 수익으로 이어진다고 밝혔다.

By 김현동 에디터 Hyundong.Kim@weeklypost.kr

〈저작권자ⓒ 위클리포스트, 무단전재 및 재배포 금지〉