전반에 걸친 협업 통해 안전한 기업용 AI 구현'

엔비디아 H100 대비 평균 50% 더 뛰어난 추론성능

평균 40% 더 우수한 전력 효율성과 뛰어난 가성비

팻 겔싱어(Pat Gelsinger) 인텔 CEO는 “모든 기업이 AI 기업으로 거듭나고 있다”라며, “가우디, 제온 및 코어 Ultra 플랫폼은 변화하는 고객과 파트너 요구를 충족하고 앞으로의 엄청난 기회를 활용할 수 있도록 유연한 솔루션 세트를 제공하고 있다”고 밝혔다.

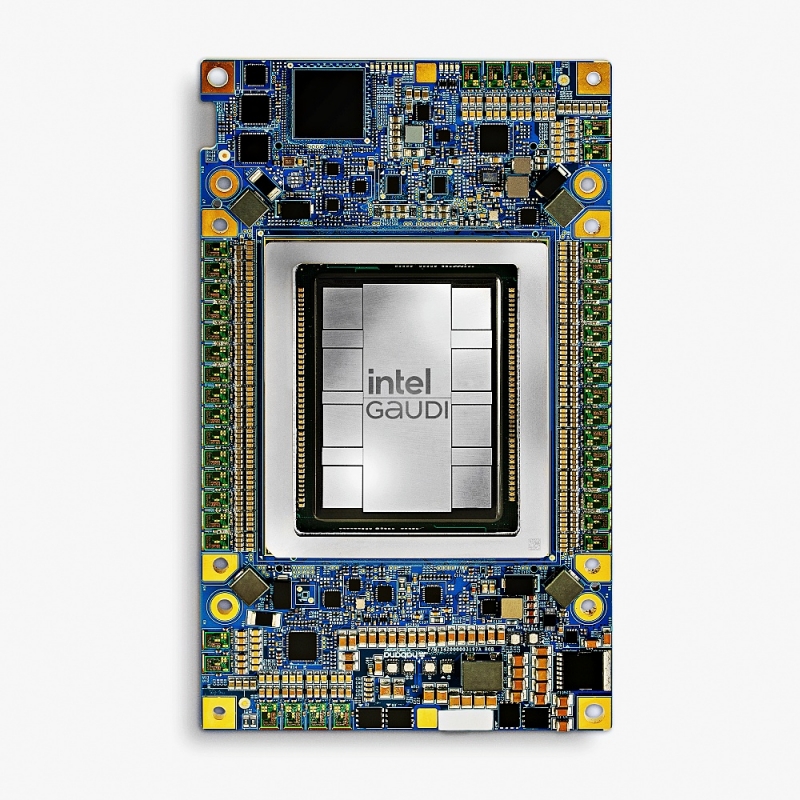

가우디 3(Intel Gaudi 3) AI 가속기는 BF16 대비 4배 더 많은 AI 컴퓨팅 및 기존 모델 대비 1.5배 커진 메모리 대역폭을 제공한다. 인텔은 엔비디아 H100과 비교하여 70억개 및 130억개의 매개변수가 있는 라마2(Llama2) 모델과 GPT-3 1750억개 매개변수 모델 전체에서 평균 50% 더 빠른 학습 시간 제공을 예고했다.

또한 가속기 추론 처리량은 평균적으로 H100보다 50%, 전력 효율성의 경우 라마(Llama) 70억개 및 700억개 매개변수와 팔콘(Falcon) 1800억개 매개변수 모델에서 평균 40% 더 우수함을 강조했다.

핵심은 하드웨어, 소프트웨어, 프레임워크, 툴 등을 포함한 개방형 스케일러블 AI 시스템 방침이다. 이러한 접근법은 장비 제조업체, 데이터베이스 공급자, 시스템 통합업체, 소프트웨어 및 서비스 공급자 등을 대상으로 기업이 일정부분 의존하는 생태계 파트너 및 솔루션을 그대로 활용할 수 있게 해 접근 문턱을 낮추는 효과를 가져온다.

** 개방형 AI 플랫폼 구축에 동참한 파트너 공개

인텔 AI 생태계에는 애니스케일(Anyscale), 아르큘8(Articul8), 데이터스택스(DataStax), 도미노(Domino), 허깅페이스(Hugging Face), KX 시스템즈(KX Systems), 마리아DB(MariaDB), MinIO, Qdrant, 레드햇(RedHat), 레디스(Redis), SAP, SAS, VMware, 옐로브릭(Yellowbrick), 질리즈(Zilliz)와 합류했다.

초기 단계로 인텔은 생성형 AI 파이프라인에 대한 안전한 인텔 제온 및 가우디 기반 솔루션의 레퍼런스를 공개하고, 기술 개념 프레임워크(technical conceptual framework)를 게시하며, 생태계 개발, RAG 및 향후 파이프라인의 검증을 위해 인텔 타이버 개발자 클라우드(Intel Tiber Developer Cloud)에 인프라 용량 확장을 예고했다.

** 복잡하던 인텔 프로세서 명칭, 단순하게 정리

인텔 프로세서 식별 방식이 더 단순해졌다. 예로 든 것은 제온(Xeon) 프로세서로, 제온 명사에 숫자 6이 더해져 제온 6로 몀여햇다. 제온6 프로세서는 RAG를 포함한 최신 생성형 AI 솔루션을 실행할 수 있한다. E-코어 기반 프로세서로 이번 분기에 출시하며 P-코어 기반 인텔 제온 6는 향상된 AI 성능에 초점을 두고 순차적으로 선보일 방침이다.

예)

E-코어 기반 인텔 제온 6 프로세서(코드명 시에라 포레스트)

P-코어 기반 인텔 제온 6 프로세서(코드명 그래나이트 래피즈)

** 기업용 생성형 AI 시장 독점 구조 타개할 가우디 3

가우디 3는 LLM(대규모 언어 모델) 및 멀티모달 모델에서 AI 학습 및 추론을 위한 성능과 생산성을 대폭 향상했다. 가우디 3 AI 가속기는 기존 가우디 2 모델의 성능 및 확장성 기반으로 BF16용 AI 컴퓨팅에서 4배, 메모리 대역폭에서 1.5배, 대규모 시스템 확장을 위한 네트워킹 대역폭은 2배 향상됐다.

5나노미터(nm) 공정으로 제조되며 MME(Matrix Multiplication Engine), 텐서 프로세서 코어(TPC), 네트워킹 인터페이스 카드(NIC) 등 모든 엔진을 병렬로 활성화할 수 있다. 각 가속기는 64개의 AI 맞춤형 및 프로그래밍 가능한 TPC와 8개의 MME로 구성된 이종 컴퓨팅 엔진으로 구성된다.

인텔은 엔비디아 H100 대비 평균적으로 3가지 이점을 강조했다.

▲ 라마(Llama2) 70억개 및 130억개의 매개변수와 GPT-3 1750억개의 매개변수 모델에서 학습 시간 50% 단축

▲ 라마 70억개 및 700억개의 매개변수 모델에서 50% 빠른 추론 처리량(스루풋) 및 40% 향상된 추론 전력 효율성 제공. 더 긴 입력/출력 시퀀스에서 더 큰 추론 성능 이점 제공

▲ 라마 70억개 및 700억개 매개변수와 팔콘(Falcon) 1800억개 매개변수 모델에서 엔비디아 H200 대비30% 빠른 추론

이번에 공개된 가우디 3 가속기는 2024년 2분기에 범용 베이스보드 및 개방형 가속기 모듈(OAM)의 산업 표준 구성으로 델 테크놀로지스(Dell Technologies), HPE, 레노보(Lenovo), 슈퍼마이크로(Supermicro) 등의 OEM 업체를 통해 출시된다. GA(General availability)는 2024년 3분기로 예정되어 있으며, PCIe 애드인 카드는 2024년 마지막 분기에 출시될 전망이다.

By 김현동 에디터 Hyundong.kim@weeklypost.kr

〈저작권자ⓒ 위클리포스트, 무단전재 및 재배포 금지〉