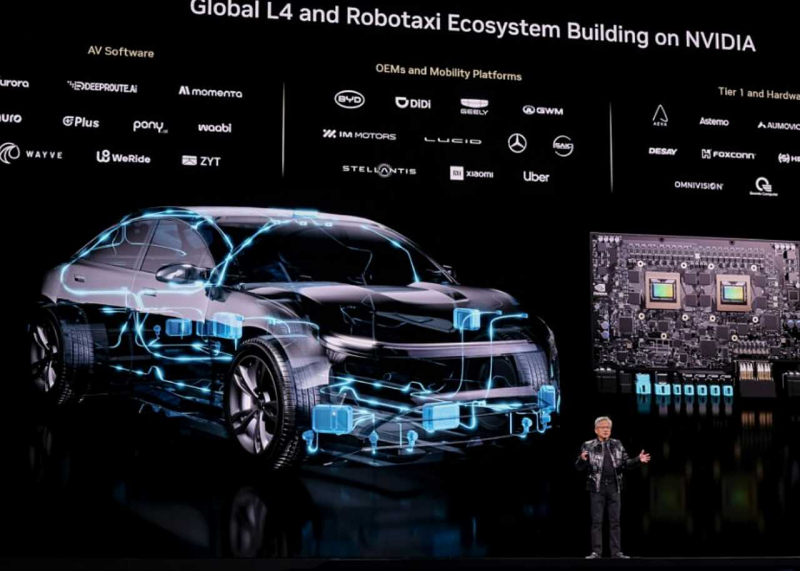

엔비디아는 CES 2026 기조연설에서 차세대 6칩 AI 플랫폼 루빈과 AI 네이티브 스토리지, 산업별 오픈 모델 포트폴리오를 공개했다. 의료, 로보틱스, 기후, 추론, 임베디드, 자율주행 영역을 겨냥한 모델과 도구를 제시했으며, 자율주행용 오픈 AI 모델 제품군 알파마요의 첫 적용 대상으로 메르세데스-벤츠 CLA를 언급했다.

엔비디아는 CES 2026 개막 연설에서 AI가 데이터센터와 엣지, 개인용 환경까지 확장되고 있다고 설명하고, 차세대 컴퓨팅 플랫폼과 오픈 모델, 피지컬 AI 전략을 발표했다. 엔비디아는 가속 컴퓨팅 확산으로 컴퓨팅 구조가 재편되고 있으며, 대규모 AI 배포를 위한 인프라와 소프트웨어 스택의 통합이 중요해지고 있다고 밝혔다.

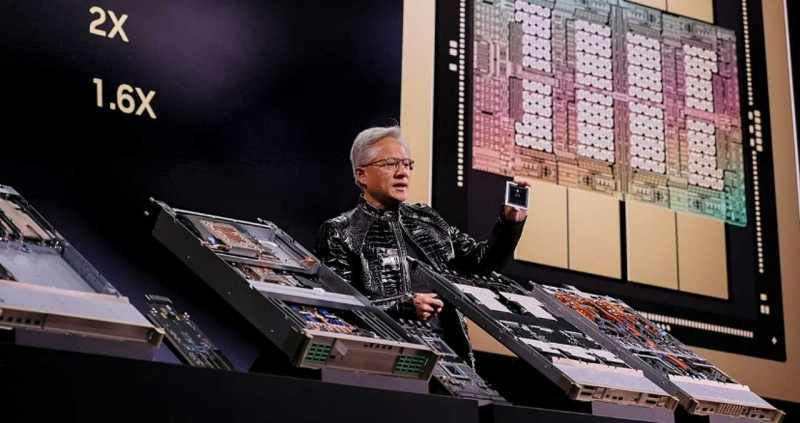

먼저 블랙웰 아키텍처의 후속 플랫폼으로 루빈을 공개했다. 루빈은 엔비디아가 고도의 공동 설계를 적용했다고 밝힌 6칩 AI 플랫폼이며, 생산 단계에 들어갔다고 설명했다. 엔비디아는 루빈 플랫폼을 통해 토큰 생성 비용을 기존 플랫폼 대비 약 10분의 1 수준으로 낮춰 대규모 AI 배포의 경제성을 높이겠다는 방향을 제시했다.

이어 루빈 플랫폼 구성을 데이터센터 중심으로 소개했다. 루빈 GPU는 NVFP4 추론 기준 50페타플롭 성능을 지원하며, 데이터 이동과 에이전트 처리용으로 설계된 베라 CPU, NVLink 6 기반 스케일업 네트워킹, Spectrum-X Ethernet Photonics 기반 스케일아웃 네트워킹, ConnectX-9 SuperNIC, BlueField-4 DPU가 함께 구성 요소로 제시됐다. 엔비디아는 칩, 트레이, 랙, 네트워킹, 스토리지, 소프트웨어까지 함께 설계하는 공동 설계 접근이 병목 제거와 비용 절감에 필요하다고 설명했다.

AI 네이티브 스토리지로 추론 컨텍스트 메모리 스토리지 플랫폼도 함께 소개했다. 엔비디아는 해당 플랫폼을 AI 네이티브 KV 캐시 계층으로 설명하며, 초당 토큰 처리량과 달러당 성능, 전력 효율이 각각 5배 개선된다고 밝혔다. 긴 컨텍스트 추론을 위한 캐시 공유와 처리 효율 개선을 목표로 한다고 설명했다.

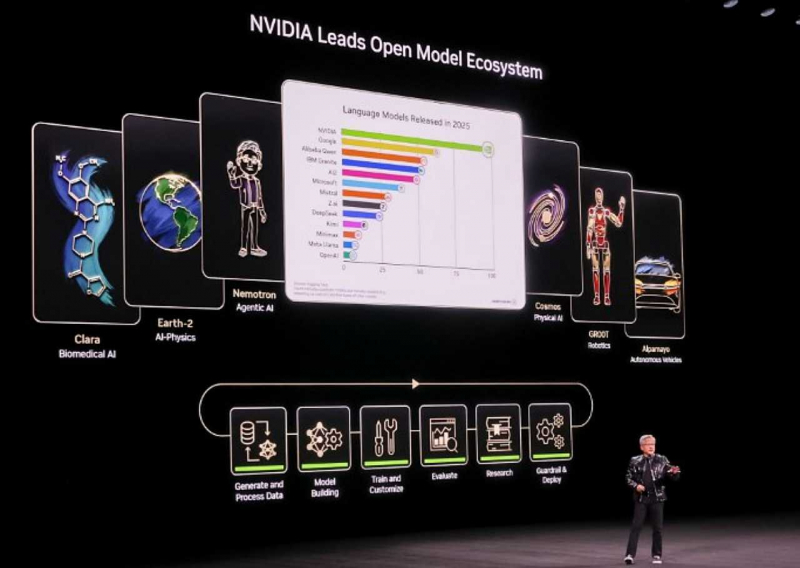

자체 슈퍼컴퓨터에서 학습된 오픈 모델 포트폴리오도 발표했다. 포트폴리오는 의료 분야 클라라, 기후 과학 분야 어스-2, 추론 및 멀티모달 분야 네모트론, 로보틱스 및 시뮬레이션 분야 코스모스, 임베디드 인텔리전스 분야 GR00T, 자율주행 분야 알파마요로 구성된다고 소개했다. 엔비디아는 이 모델들이 공개 형태로 제공돼 기업과 산업, 국가 단위에서 모델 생성, 평가, 가드레일 적용, 배포를 수행할 수 있도록 설계됐다고 밝혔다.

개인용 환경에서는 RTX 기반 로컬 실행과 DGX 스파크를 언급했다. 엔비디아는 DGX 스파크 데스크톱 슈퍼컴퓨터에서 로컬로 실행되는 개인용 AI 에이전트 데모를 공개했으며, 오픈 모델과 로컬 실행이 에이전트의 반응성과 활용도를 높일 수 있다고 설명했다. 엔비디아는 여러 기업이 자사 제품에 엔비디아 AI를 통합하고 있다고도 밝혔다.

press@weeklypost.kr